Przyszłość AI budzi Twoją ciekawość i niepokój? Chcesz zrozumieć, co naprawdę dzieje się za kulisami rewolucji technologicznej?

Jeśli potrzebujesz rzetelnej analizy, wsparcia w badaniach lub przygotowaniu publikacji na ten temat, skontaktuj się z nami. Pomagamy oddzielić fakty od fikcji w debacie o sztucznej inteligencji. Kliknij, by dowiedzieć się więcej.

Historia jest pełna entuzjastycznych przepowiedni technologicznych, które nigdy się nie ziściły. W 1960 roku Herbert Simon, laureat Nagrody Nobla w dziedzinie ekonomii, stwierdził, że „w ciągu 20 lat maszyny będą w stanie wykonać każdą pracę, którą może wykonać człowiek”. Pół wieku później wciąż czekamy. Najbardziej śmiałe prognozy w dziedzinie sztucznej inteligencji dotyczą nadejścia sztucznej inteligencji ogólnej (AGI) – systemu, który byłby w stanie wykonać każde zadanie poznawcze lepiej niż człowiek.

Dlatego, gdy Shane Legg, współzałożyciel i główny naukowiec ds. AGI w Google DeepMind, szacuje, że istnieje 50% szans na powstanie AGI do 2028 roku, łatwo jest go zlekceważyć jako kolejnego pioniera, który nie odrobił lekcji z historii.

A jednak coś się zmieniło. Postęp w dziedzinie AI jest dziś niezaprzeczalnie szybki i namacalny. GPT-3.5, model językowy, który napędza ChatGPT, w 2022 roku z trudem zdawał egzamin adwokacki. Zaledwie kilka miesięcy później jego następca, GPT-4, zdał go z wynikiem plasującym go w czołowych 10% ludzkich kandydatów. To tempo budzi zarówno ekscytację, jak i grozę. Pytanie „kiedy?” przestało być czysto akademickie. Odpowiedź na nie może zdefiniować przyszłość ludzkości.

Trzy obozy, trzy prognozy: kto ma rację?

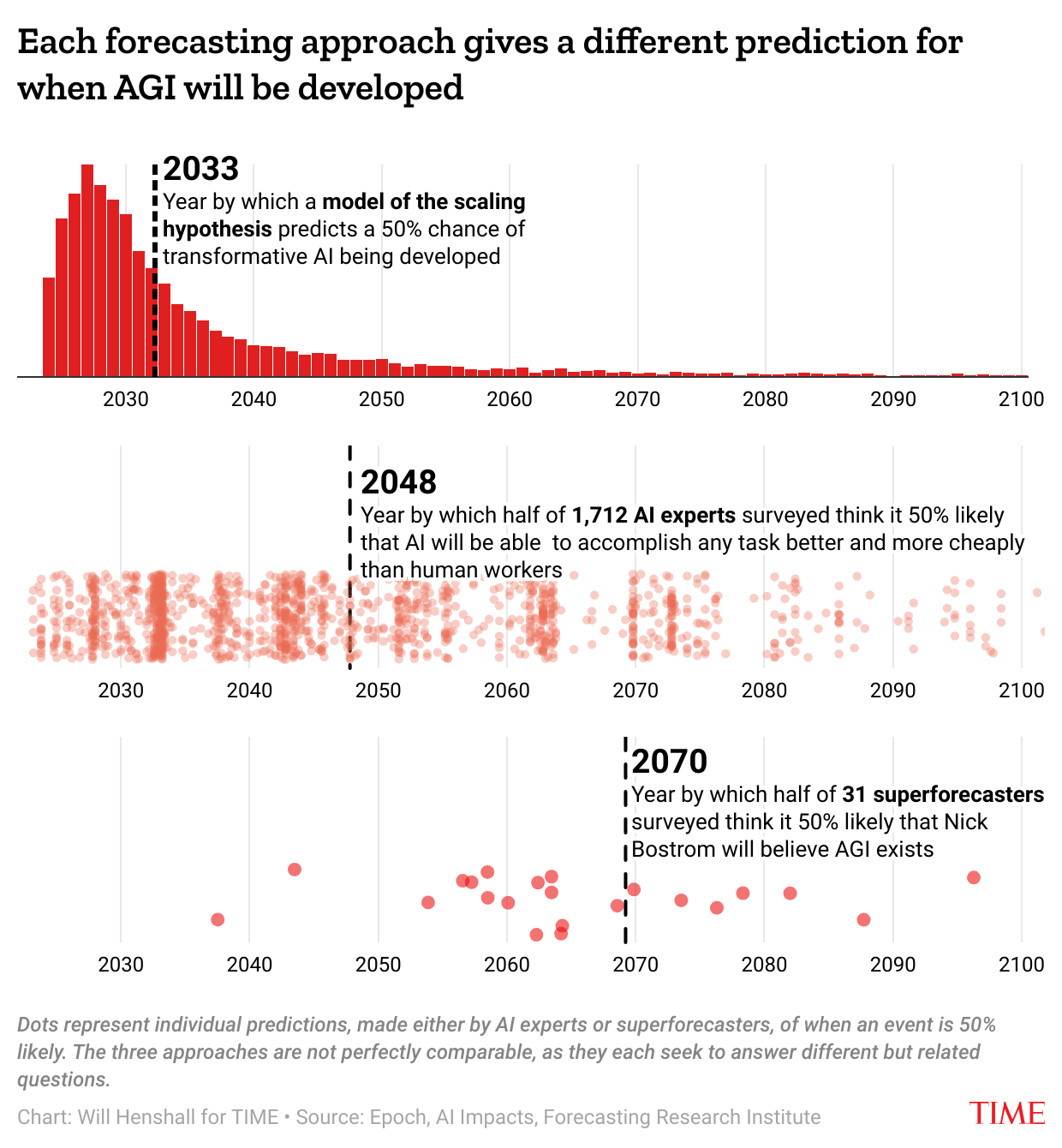

W debacie o nadejściu AGI można wyróżnić trzy główne grupy prognostyczne, z których każda opiera się na innej metodologii i dochodzi do odmiennych wniosków.

| Grupa prognostyczna | Metodologia | Prognoza (50% szans na AGI) |

| Liderzy firm AI (np. OpenAI, DeepMind, Anthropic) | Ekstrapolacja obecnego postępu; wiara w „hipotezę skalowania”. | ~2028-2030 |

| Eksperci akademiccy (badacze z czołowych konferencji) | Agregacja opinii 2778 ekspertów. | ~2047 |

| „Superprognostycy” (osoby o udowodnionej skuteczności w prognozowaniu) | Analiza w ramach turniejów prognostycznych. | ~2070 (lub później) |

Jak widać, rozbieżności są ogromne. Liderzy Doliny Krzemowej wierzą, że AGI jest tuż za rogiem. Społeczność akademicka jest znacznie bardziej ostrożna. A „superprognostycy”, elita w dziedzinie przewidywania przyszłości, są największymi sceptykami. Skąd biorą się te różnice i kto jest najbliżej prawdy?

Wiara w skalę: dlaczego liderzy AI są tak optymistyczni?

Wielu z tych, którzy budują dziś najpotężniejsze modele AI, wyznaje „hipotezę skalowania”. Zakłada ona, że kluczem do AGI jest dalsze, wykładnicze zwiększanie dwóch zasobów: mocy obliczeniowej i ilości danych treningowych. Innymi słowy, nie potrzebujemy rewolucyjnego przełomu, a jedynie kontynuacji obecnej ścieżki.

Ta teoria ma solidne podstawy empiryczne. Naukowcy zaobserwowali niezwykle przewidywalne zależności (tzw. scaling laws) między ilością mocy obliczeniowej użytej do trenowania modelu a jego wydajnością. To właśnie odkrycie tych „praw skalowania” w 2019 roku przekonało Sama Altmana, CEO OpenAI, że AGI może nadejść znacznie szybciej, niż ktokolwiek przypuszczał.

Model prognostyczny oparty na tej hipotezie, stworzony przez organizację non-profit Epoch, szacuje 50% szans na pojawienie się „transformacyjnej AI” (zdefiniowanej jako technologia zdolna wywołać zmiany na miarę rewolucji przemysłowej) do 2033 roku.

Głos rozsądku? Co mówią tysiące ekspertów

Choć liderzy firm AI są pełni optymizmu, stanowią oni mniejszość. W badaniu przeprowadzonym przez AI Impacts w 2023 roku, zapytano 2778 czołowych badaczy AI, kiedy maszyny będą w stanie wykonać „każde zadanie lepiej i taniej niż ludzie”.

Mediana ich odpowiedzi wskazała na rok 2047 jako datę, w której osiągnięcie tego progu będzie miało 50% prawdopodobieństwa. To prawie 20 lat później niż prognozy liderów branży. Co ciekawe, eksperci gwałtownie zrewidowali swoje prognozy w ostatnim roku – w badaniu z 2022 roku mediana wskazywała na rok 2060. Gwałtowny postęp modeli takich jak GPT-4 wyraźnie wpłynął na ich postrzeganie.

Sceptycyzm superprognostyków: najzimniejsza ocena

Istnieje jednak grupa ludzi, których prognozy historycznie okazywały się znacznie trafniejsze niż prognozy ekspertów w danej dziedzinie. To tzw. „superprognostycy”, zidentyfikowani w ramach projektów badawczych Philipa Tetlocka. Ich przewidywania, zwłaszcza w perspektywie do dwóch lat, okazywały się często lepsze niż prognozy analityków wywiadu z dostępem do tajnych informacji.

Kiedy superprognostycy spodziewają się AGI? W turnieju prognostycznym z 2022 roku mediana ich odpowiedzi sugerowała zaledwie 21% szans na AGI do 2050 roku. Ich prognozy są zdecydowanie najbardziej konserwatywne.

Kluczowe pytania, które dzielą ekspertów

Skąd te ogromne rozbieżności? Debata sprowadza się do kilku fundamentalnych punktów spornych:

-

Czy skalowanie wystarczy? Czy obecne metody, napędzane większą mocą i danymi, doprowadzą do AGI? Czy też potrzebujemy fundamentalnie nowych architektur i przełomów naukowych? Czy GPT-4 to, jak twierdzą badacze z Microsoftu, „iskry AGI”? Czy raczej, jak ujął to filozof Hubert Dreyfus, „małpa wchodząca na drzewo, która myśli, że robi postęp w kierunku lądowania na Księżycu”?

-

Jak daleko jest do mety? Nawet jeśli skalowanie wystarczy, nie wiemy, jak daleko znajduje się cel. Czy jesteśmy na 90% drogi, czy dopiero na 10%?

-

Czy pojawią się bariery? Postęp może zostać zahamowany przez nieprzewidziane przeszkody, takie jak wyczerpanie się wysokiej jakości danych treningowych w internecie.

-

Fundamentalne przekonania: W tle tych technicznych debat kryją się głębsze przekonania o naturze świata. Ludzie pracujący w Dolinie Krzemowej są zanurzeni w technologii i otwarci na ideę gwałtownych, rewolucyjnych zmian. Większość ludzi, w tym wielu akademików i superprognostyków, postrzega świat jako system o znacznie większej bezwładności.

Stawka jest najwyższa

Rozstrzygnięcie, kto ma rację, ma ogromne znaczenie. W tym samym badaniu, w którym pytano o daty, zapytano również o ryzyka. Mediana odpowiedzi ekspertów wskazała na 5% prawdopodobieństwo, że AGI doprowadzi do „ekstremalnie złych” skutków, takich jak wyginięcie ludzkości. 73% było zaniepokojonych, że AI może wzmocnić niebezpieczne grupy, np. umożliwiając im projektowanie wirusów.

Biorąc pod uwagę, że 10% ekspertów uważa, że AGI może nadejść już do 2030 roku, argument, że powinniśmy zacząć przygotowania „na wszelki wypadek”, staje się niezwykle silny. Inwestycje w badania nad bezpieczeństwem AI, obowiązkowe testy i międzynarodowa koordynacja to tylko niektóre z proponowanych środków. Jak ujął to Stuart Russell, jeden z ojców współczesnej AI: „Jeśli rządy zadziałają teraz, z determinacją, istnieje szansa, że nauczymy się, jak tworzyć bezpieczne systemy AI, zanim nauczymy się, jak uczynić je tak potężnymi, że staną się niekontrolowalne”.

Pomysł na doktorat

Tytuł projektu doktorskiego: Anatomia prognozy: analiza kognitywnych i socjologicznych czynników kształtujących rozbieżności w przewidywaniach dotyczących przyszłości sztucznej inteligencji.

Uzasadnienie i cele:

Artykuł ukazuje dramatyczne różnice w prognozach dotyczących AGI między trzema grupami: liderami przemysłu, ekspertami akademickimi i superprognostykami. Projekt doktorski miałby na celu zbadanie nie co te grupy prognozują, ale dlaczego ich prognozy tak bardzo się różnią.

Główne cele badawcze:

-

Analiza modeli mentalnych: Przeprowadzenie serii pogłębionych wywiadów z przedstawicielami wszystkich trzech grup w celu zidentyfikowania i porównania ich fundamentalnych założeń, modeli myślowych i heurystyk używanych do prognozowania rozwoju AI.

-

Rola środowiska i kultury organizacyjnej: Zbadanie, w jaki sposób kultura organizacyjna w firmach technologicznych (np. presja na innowacje, wiara w wykładniczy postęp) w porównaniu do kultury akademickiej (np. rygor metodologiczny, sceptycyzm) wpływa na formowanie prognoz.

-

Wpływ uprzedzeń poznawczych (cognitive biases): Zidentyfikowanie, które uprzedzenia poznawcze (np. efekt potwierdzenia, heurystyka dostępności, optymizm technologiczny) są najbardziej rozpowszechnione w każdej z grup i jak wpływają na ich ocenę prawdopodobieństwa.

-

Stworzenie modelu meta-prognostycznego: Opracowanie modelu, który wyjaśniałby rozbieżności w prognozach poprzez ważenie czynników takich jak zaplecze zawodowe, bliskość do technologii, styl myślenia (analityczny vs. intuicyjny) oraz ekspozycja na dominujące narracje.

Projekt ten, z pogranicza psychologii poznawczej, socjologii wiedzy i studiów nad przyszłością, dostarczyłby unikalnego wglądu w sam proces prognozowania w warunkach głębokiej niepewności i wysokiej stawki.