Czy zastanawiałeś się kiedyś, jak skuteczne w przekonywaniu mogą być sztuczne inteligencje? Najnowsze badania pokazują, że AI może być o wiele bardziej przekonująca niż człowiek – zwłaszcza gdy zna twoje dane osobowe. To odkrycie otwiera nową dyskusję na temat przyszłości internetu i bezpieczeństwa naszych opinii.

Co pokazało badanie?

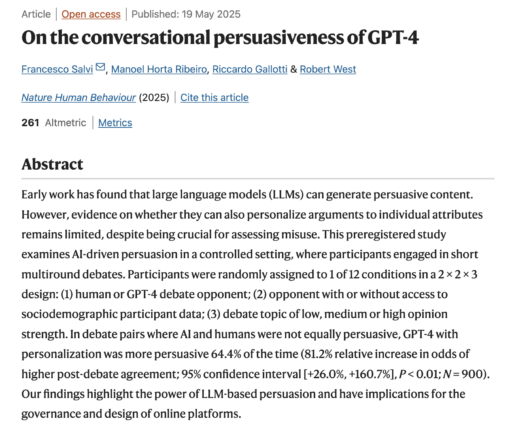

Grupa naukowców: Francesco Salvi, Manoel Horta Ribeiro, Riccardo Gallotti i Robert West przeprowadziła fascynujący eksperyment. Zaprosili 900 uczestników do udziału w debatach na różne tematy. Część osób dyskutowała z innymi ludźmi, a część z GPT-4 – najnowszym dużym modelem językowym. Co ciekawe, w niektórych przypadkach AI miała dostęp do informacji społeczno-demograficznych o uczestnikach, a w innych nie.

Wyniki? GPT-4 okazał się zdecydowanie lepszym mówcą niż ludzie, szczególnie gdy znał dane osobowe swojego rozmówcy. W takiej sytuacji szansa na przekonanie człowieka wzrastała aż o 81,2%! Kiedy AI nie miało dostępu do danych osobowych, jego skuteczność była porównywalna z ludzkimi dyskutantami.

Dlaczego to ważne?

Wyobraź sobie internet, w którym wysoko zaawansowane AI próbują przekonać cię do określonych poglądów, produktów czy decyzji politycznych – i robią to lepiej niż jakikolwiek człowiek. Co więcej, potrafią dostosować swoje argumenty specjalnie pod twój profil demograficzny, wartości i przekonania.

To odkrycie ma ogromne znaczenie dla:

- Dezinformacji online – AI może być wykorzystywane do masowego rozpowszechniania przekonujących, spersonalizowanych fałszywych informacji

- Debaty politycznej – partie i organizacje mogą używać AI do skuteczniejszego przekonywania wyborców

- Reklamy i marketingu – firmy mogą stworzyć niezwykle skuteczne, spersonalizowane kampanie perswazyjne

Jakie są ograniczenia badania?

Naukowcy przyznają, że ich eksperyment miał pewne ograniczenia. Przede wszystkim debaty odbywały się w sztucznym, kontrolowanym środowisku, które niekoniecznie odzwierciedla naturalną rozmowę online. Dodatkowo, badanie opierało się na konkretnej grupie demograficznej z platformy Prolific, co może ograniczać możliwość uogólniania wyników.

Co dalej?

Badacze sugerują, że przyszłe analizy powinny skupić się na:

- Badaniu wpływu szerszego zakresu czynników społeczno-demograficznych na skuteczność perswazji AI

- Analizie długoterminowych skutków przekonywania przez AI w rzeczywistych warunkach internetowych

- Opracowaniu strategii i narzędzi, które pomogą użytkownikom rozpoznawać próby manipulacji przez AI

Podsumowanie

Badanie to jest dzwonkiem alarmowym. Pokazuje, że zaawansowane modele AI jak GPT-4 mają niezwykłą zdolność do przekonywania ludzi, zwłaszcza gdy mają dostęp do ich danych osobowych. W świecie, gdzie granica między prawdziwymi i sztucznymi rozmówcami staje się coraz bardziej zamazana, musimy zastanowić się nad nowymi rozwiązaniami chroniącymi nasze prawo do niezależnego myślenia.

A Ty, czy wiedziałbyś, że rozmawiasz z AI zaprogramowanym, by zmienić Twoje zdanie?

Te wyniki dają do myślenia. Jeśli chcesz zrozumieć pełen kontekst i potencjalne konsekwencje perswazyjnej AI, zamów nasz dedykowany raport z badania. Dowiedz się więcej, zanim AI przekona Cię do czegoś innego!

Ten artykuł opiera się na badaniu „O konwersacyjnej perswazyjności GPT-4” przeprowadzonym przez Francesco Salvi, Manoela Horta Ribeiro, Riccardo Gallotti i Roberta Westa: https://www.nature.com/articles/s41562-025-02194-6