Sztuczna inteligencja przestała być technologiczną nowinką, a stała się kluczowym elementem strategii biznesowej. Firmy inwestują miliardy w systemy AI, widząc w nich obietnicę hiperpersonalizacji, automatyzacji i bezprecedensowej efektywności. W tym pędzie ku innowacji zarządy często zakładają, że doskonale rozumieją, czego chcą i czego obawiają się ich klienci. To założenie, jak pokazują twarde dane, jest nie tylko błędne, ale i niebezpieczne.

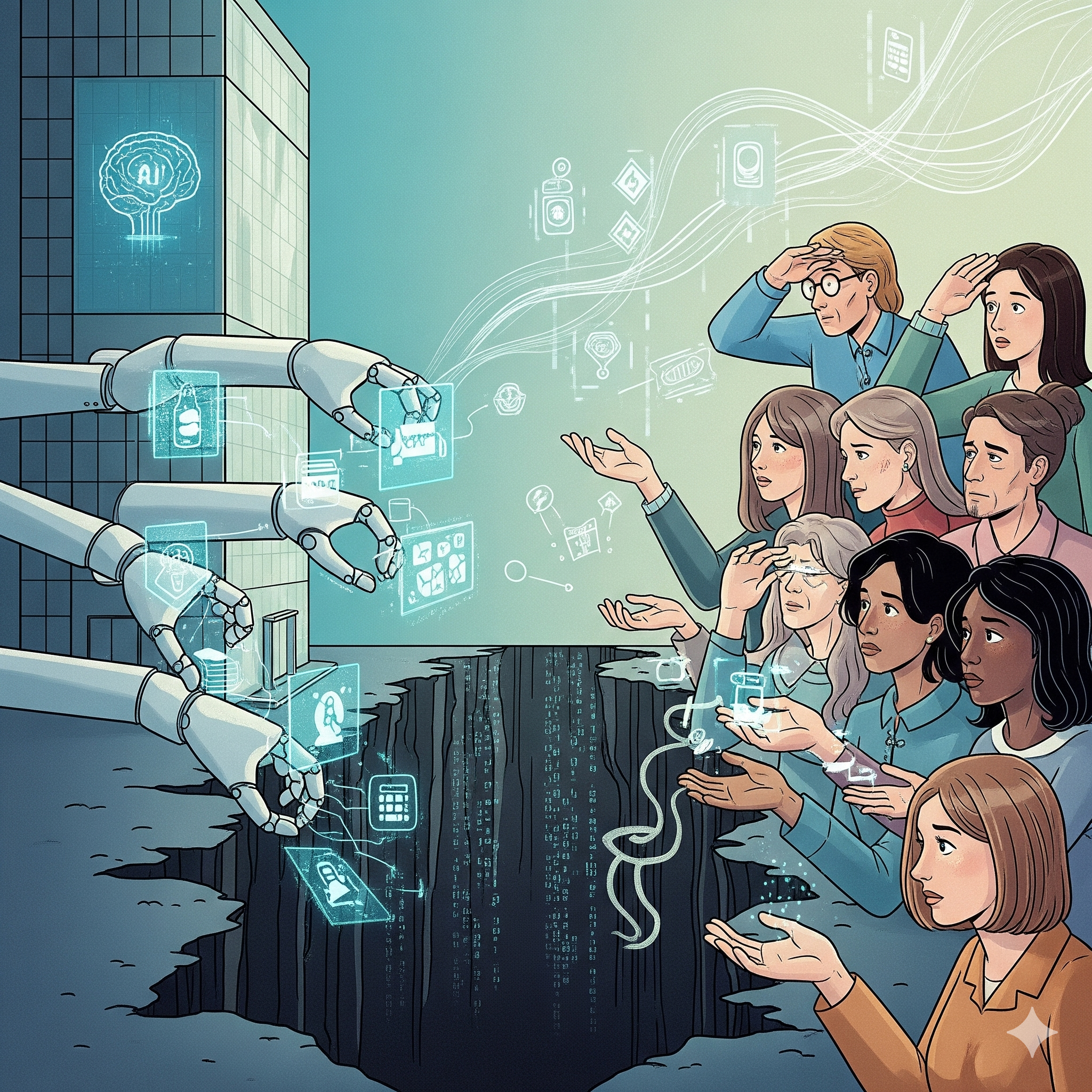

Istnieje systemowa przepaść między tym, jak liderzy biznesu postrzegają AI, a realnymi odczuciami konsumentów. Ignorowanie tej luki to nie tylko ryzyko nietrafionej inwestycji. To ryzyko utraty najcenniejszego kapitału w gospodarce cyfrowej: zaufania. Zrozumienie natury tego rozdźwięku jest kluczowe nie tylko dla menedżerów, ale dla każdego, kto chce zrozumieć dynamikę współczesnego rynku.

Diagnoza: niebezpieczna luka w percepcji, potwierdzona danymi

Międzynarodowe badanie dotyczące postaw wobec AI przynosi niepokojący obraz. Aż 63% menedżerów wyższego szczebla jest przekonanych, że ich punkt widzenia na AI jest zbieżny z perspektywą klientów. Rzeczywistość jest jednak inna. Konsumenci i zarządy żyją w dwóch odrębnych światach, jeśli chodzi o postrzeganie ryzyka. Różnice są uderzające.

| Obszar ryzyka związanego z AI | Odsetek zarządów postrzegających to jako duży problem | Odsetek konsumentów postrzegających to jako duży problem | Luka w percepcji (różnica w p.p.) |

| Brak odpowiedzialności za szkodliwe użycie AI | 23% | 58% | 35 |

| Naruszenia systemów bezpieczeństwa AI | 32% | 64% | 32 |

| Niewystarczająca ochrona prywatności | 31% | 61% | 30 |

| Nieprzestrzeganie regulacji dotyczących AI | 23% | 52% | 29 |

Dane te pokazują, że tam, gdzie konsumenci widzą poważne zagrożenie, zarządy często dostrzegają jedynie niewielki problem. Ta dysproporcja nie jest przypadkowa – ma swoje strukturalne przyczyny.

Przyczyny rozdźwięku: dlaczego zarządy i klienci myślą inaczej?

Aby zrozumieć tę lukę, należy rozłożyć ją na czynniki pierwsze. Problem nie leży w złej woli, lecz w odmiennych perspektywach i priorytetach.

-

Bańka innowatorów i presja konkurencyjna. Zarządy funkcjonują w środowisku, gdzie AI jest codziennym tematem, a kluczowym celem jest uzyskanie przewagi rynkowej. „Być pierwszym” staje się strategicznym imperatywem, który spycha kwestie ryzyka na niższy priorytet. W tej bańce łatwo stracić z oczu perspektywę zwykłego użytkownika, dla którego AI wciąż jest nową i nie do końca zrozumiałą technologią.

-

Paradoks doświadczenia. Badanie ujawnia zaskakującą zależność: im bardziej zaawansowana firma we wdrażaniu AI, tym większe przekonanie jej zarządu o zrozumieniu klienta (wzrost z 51% do 71%). Prowadzi to do paradoksu, w którym większe doświadczenie technologiczne koreluje z większym ryzykiem rozminięcia się z realnymi obawami rynku.

-

Asymetria wiedzy i percepcji. Dla lidera biznesu AI to narzędzie do optymalizacji. Dla konsumenta to często „czarna skrzynka”, której działanie jest niejasne. Ta przepaść w świadomości sprawia, że obawy klienta, racjonalizowane argumentami o prywatności i bezpieczeństwie, są przez firmy postrzegane jako irracjonalny opór przed zmianą.

-

Różnica w tempie adaptacji. Rozwój technologiczny postępuje w tempie wykładniczym. Zmiana nawyków społecznych i budowanie zaufania to procesy liniowe i powolne. Firmy, pędząc z innowacjami, nie dają rynkowi czasu na „oswojenie” nowych rozwiązań, co naturalnie rodzi opór.

Konsekwencje w praktyce: cztery pola minowe we wdrażaniu AI

Ta fundamentalna luka w percepcji materializuje się w konkretnych obszarach biznesowych, tworząc ryzyko strategicznych błędów.

-

Gromadzenie danych i hiperpersonalizacja. Firmy widzą w tym szansę na idealnie dopasowaną ofertę. Klienci obawiają się, że dane o ich zachowaniach (np. brawurowej jeździe samochodem) zostaną wykorzystane przeciwko nim, np. do podniesienia składki ubezpieczeniowej. Granica między atrakcyjną ofertą a przekroczeniem granic prywatności jest cienka.

-

Automatyzacja obsługi klienta. Dla firmy chatbot to redukcja kosztów i efektywność. Dla klienta, który ma złożony problem, rozmowa wyłącznie z maszyną bywa źródłem frustracji i poczucia bycia zignorowanym, co może prowadzić do rezygnacji z usług.

-

Wyścig technologiczny. Przedsiębiorcy postrzegają AI jako kluczowy element strategii i przewagi konkurencyjnej. Konsumenci niekoniecznie chcą brać udział w tym wyścigu. Ich wybory często dyktowane są przyzwyczajeniami, a nie najnowszą technologią.

-

Zaufanie i reputacja. Największym kosztem nie jest nietrafiona inwestycja finansowa, ale utrata reputacji. Wdrożenie systemu AI, który nie spełnia oczekiwań (np. generuje „halucynacje” lub jest nielogiczny), może prowadzić do masowego odpływu klientów i utraty zaufania, którego nie da się odbudować kampanią reklamową.

Jak zasypać tę przepaść? Odpowiedzialna innowacja jako maraton

Pogoń za innowacjami bez zrozumienia rynku prowadzi w ślepy zaułek. Rozwiązaniem nie jest zatrzymanie postępu, lecz zmiana filozofii wdrażania – z technocentrycznej na ludzką.

-

Edukacja i transparentność: Kluczem jest rzetelna edukacja. Klienci muszą rozumieć nie tylko korzyści, ale też podstawowe zasady działania technologii i mechanizmy zabezpieczeń. Komunikacja musi być prosta, uczciwa i pozbawiona technicznego żargonu.

-

Stopniowe wdrażanie: Zamiast rewolucji, lepsza jest ewolucja. Wprowadzanie nowości etapami, testowanie ich w małych grupach i zbieranie informacji zwrotnej przed pełnym wdrożeniem pozwala „oswoić” rynek i dopasować rozwiązanie do realnych potrzeb.

-

Odpowiedzialność i zgodność z prawem: Nowe regulacje, takie jak unijny AI ACT, nakładają na firmy konkretne obowiązki, zakazując m.in. technik manipulacyjnych. Ignorowanie ram prawnych to nie tylko ryzyko ogromnych kar finansowych, ale także dowód na brak dbałości o dobro klienta.

FAQ – Najczęściej zadawane pytania

-

Czy obawy konsumentów dotyczące AI są przesadzone?

Niekoniecznie. Chociaż czasem wynikają z braku wiedzy, często są racjonalną reakcją na realne ryzyka, takie jak wycieki danych, stronniczość algorytmów czy brak transparentności w podejmowaniu decyzji. Traktowanie tych obaw jako „irracjonalnego oporu” jest błędem strategicznym firm. -

Czy mniejsze firmy mają ten sam problem co duże korporacje?

Problem może mieć inną skalę, ale jego natura jest podobna. Mniejsze firmy mogą być bardziej elastyczne i bliższe klientom, co potencjalnie zmniejsza lukę. Z drugiej strony, mogą mieć mniej zasobów na edukację rynku i solidne testy, co zwiększa ryzyko nieudanego wdrożenia. -

Czy to oznacza, że firmy powinny spowolnić wdrażanie AI?

Niekoniecznie spowolnić, ale z pewnością uczynić ten proces bardziej przemyślanym. Chodzi o przesunięcie akcentu z „jak najszybciej” na „jak najlepiej”, co oznacza więcej czasu na badania, testy z użytkownikami i edukację, nawet kosztem bycia drugim na rynku. -

Jak w praktyce wygląda „dobra edukacja” konsumentów w zakresie AI?

To prosta, przejrzysta komunikacja, która unika żargonu. Powinna wyjaśniać trzy rzeczy: 1) Jaką korzyść daje to rozwiązanie klientowi? 2) Na jakiej ogólnej zasadzie działa (bez wchodzenia w szczegóły techniczne)? 3) Jakie mechanizmy chronią jego dane i prywatność? -

Czy obawy o prywatność nie znikną, gdy klienci przyzwyczają się do wygody?

Historia pokazuje, że często tak się dzieje. Jednak w przypadku AI, którego zdolność do przetwarzania danych jest bezprecedensowa, świadomość ryzyka może rosnąć, a nie maleć. Firmy, które założą, że wygoda zawsze wygra z prywatnością, mogą się mylić, zwłaszcza w obliczu głośnych incydentów bezpieczeństwa.

Publikacje wykonane przez nas w podobnej tematyce

-

Luka percepcji AI: Analiza ilościowa rozbieżności w postrzeganiu ryzyka między zarządami a konsumentami w sektorze finansowym.

-

Przekraczając cyfrową przepaść: Model stopniowej adaptacji technologii AI w strategiach marketingowych B2C.

-

Ekonomia zaufania w erze algorytmów: Wpływ transparentności modeli AI na lojalność klientów.

-

Paradoks innowatora: Jak wewnętrzna kultura technologiczna w firmach prowadzi do niezrozumienia potrzeb rynku.

-

Komunikacja wdrożeń AI: Analiza dyskursu i najlepsze praktyki w budowaniu zaufania konsumentów.

Pomysł na doktorat

Tytuł: Wpływ ramowania komunikacyjnego (gain vs. loss framing) na percepcję ryzyka i tempo adopcji usług opartych na AI w sektorze ubezpieczeniowym: Badanie eksperymentalne.

Opis: Projekt badałby, jak sposób komunikacji o nowej usłudze AI (np. telematyka w ubezpieczeniach komunikacyjnych) wpływa na jej akceptację. Porównywano by dwie grupy konsumentów: jednej przedstawiano by korzyści (gain frame: „możesz zaoszczędzić na składce”), a drugiej – potencjalne straty, których można uniknąć (loss frame: „unikniesz podwyżki za ryzykowną jazdę”). Badanie weryfikowałoby hipotezę, że komunikacja oparta na unikaniu strat jest skuteczniejsza w przezwyciężaniu barier związanych z obawami o prywatność.

Firmy kontra klienci w erze AI: Niebezpieczna luka w zaufaniu, której nie widać by www.doktoraty.pl