Kiedy stworzymy Boga? Wyścig do superinteligencji i miliardy, które go napędzają

Największe firmy technologiczne na świecie, tzw. „hyperscalers”, wierzą, że w ciągu najbliższych kilku lat mogą zbudować Boga. Nie jest to metafora ani cytat z filmu science fiction. To surowa, biznesowa kalkulacja, która napędza inwestycje w sztuczną inteligencję idące w miliardy, a wkrótce w biliony dolarów.

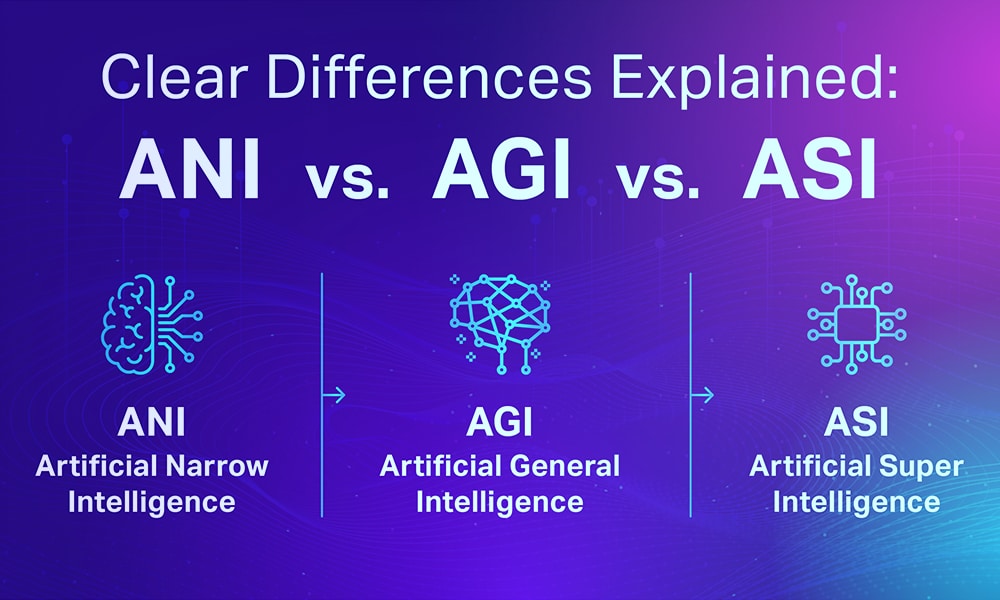

Wierzą oni, że jesteśmy o krok od AGI (Artificial General Intelligence) – momentu, w którym AI będzie w stanie wykonywać niemal wszystkie wirtualne zadania lepiej niż jakikolwiek człowiek. A stamtąd, jak twierdzą, jest już prosta droga do superinteligencji – bytu tak dalece przewyższającego nas intelektualnie, że jego myśli będą dla nas niezgłębione. Bytu, który dla naszych ograniczonych umysłów będzie tym, czym dla mrówek jest człowiek. Bogiem.

Gdyby uważali, że zajmie to 10, 20 czy 30 lat, nie inwestowaliby tak gigantycznych pieniędzy. Wyścig nie byłby tak bezwzględny. Kluczowe pytanie brzmi: dlaczego są tak pewni, że stanie się to teraz, w ciągu najbliższych kilku lat? Jeśli mają rację, oznacza to, że nie jesteśmy w bańce AI. Wręcz przeciwnie, jesteśmy niedoinwestowani, a nasze życie wkrótce zostanie wywrócone do góry nogami. Jeśli się mylą, znajomość ich argumentów może pozwolić uniknąć katastrofy finansowej.

Czym jest AGI i dlaczego kluczem jest automatyzacja naukowców?

Dzisiejsze modele językowe są inteligentne, ale nie potrafią jeszcze samodzielnie „wykonywać pracy”. Brakuje im zdolności do rozumienia kontekstu, uczenia się w działaniu, podejmowania inicjatywy i interakcji ze światem. AGI można zdefiniować jako moment, w którym AI będzie w stanie samodzielnie wykonać zadanie, które człowiekowi zajęłoby kilka tygodni intensywnej, niezależnej pracy.

Dla niektórych zawodów, jak woźny, będzie to niezwykle trudne ze względu na fizyczny charakter i różnorodność zadań. Ale dla innych, jak badacz AI, droga do automatyzacji wydaje się zaskakująco krótka. Praca badacza AI jest w pełni wirtualna i sprowadza się do cyklu: czytanie literatury, formułowanie hipotez, implementacja eksperymentów i interpretacja wyników.

To kluczowe spostrzeżenie, ponieważ automatyzacja badaczy AI uruchamia potężne sprzężenie zwrotne: lepsza AI tworzy jeszcze lepszą AI, w tempie wykładniczym. Dlatego praktyczną definicją AGI staje się „AI zdolne do zastąpienia badaczy AI”. To jest punkt zapalny, od którego droga do superinteligencji staje się prosta i krótka.

Kiedy zautomatyzujemy badaczy AI? Dowody są niepokojąco spójne

Argumenty przemawiające za tym, że stanie się to w ciągu najbliższych kilku lat, opierają się na kilku filarach.

1. Przewidywalne prawa skalowania

Już w 2020 roku naukowcy odkryli tzw. „prawa skalowania”. Okazało się, że wydajność modeli językowych (mierzona jako „strata”, czyli liczba błędów) poprawia się w sposób przewidywalny i liniowy wraz ze zwiększaniem mocy obliczeniowej, ilości danych i rozmiaru modelu. Ta zależność sprawdziła się na przestrzeni siedmiu rzędów wielkości! Wniosek jest prosty: nie potrzebujemy magii, wystarczy „wrzucić” do systemu więcej zasobów, a modele staną się inteligentniejsze.

2. Wykładniczy wzrost złożoności zadań

Obserwujemy to w praktyce. Co kilka miesięcy modele AI są w stanie z powodzeniem wykonywać coraz dłuższe i bardziej złożone zadania. Wzrost ten jest wykładniczy. Zdolność do wykonywania dłuższych zadań jest bezpośrednio związana z redukcją błędów. W wieloetapowym procesie błędy kumulują się i nawarstwiają. Jeśli w każdym ze 100 kroków mamy 99% szans na sukces, na końcu prawdopodobieństwo powodzenia całego procesu wynosi zaledwie 36%. Ale jeśli poprawimy skuteczność każdego kroku do 99.9%, końcowy sukces wzrasta do ponad 90%. Wykładniczy wzrost długości zadań oznacza więc wykładniczą poprawę niezawodności.

3. Nieubłagany marsz przez benchmarki

Kolejne testy porównawcze („evals”), zaprojektowane, by mierzyć inteligencję AI, są pokonywane w coraz krótszym czasie. Benchmark „Humanity’s Last Exam”, który miał pozostać wyzwaniem przez dekady, w ciągu niecałego roku został „rozwiązany” w 32% przez GPT-5 (wzrost z 3%).

Co najważniejsze, istnieją już benchmarki, które bezpośrednio porównują AI z ludzkimi badaczami. Na RE-Bench, starsze modele, jak Claude 3.5, już dziś pokonują ludzkich ekspertów w zadaniach trwających do 2-4 godzin. W miarę wydłużania czasu, ludzie wciąż zyskują przewagę, ale systematyczny wzrost zdolności AI do wykonywania dłuższych zadań sugeruje, że ta przewaga szybko topnieje.

Poniższa tabela ilustruje postęp AI na różnych frontach.

| Dziedzina | Przykładowy benchmark | Obserwowany postęp |

| Zadania ogólne | Różne testy (MMLU, HellaSwag) | Wykładniczy wzrost wyników z każdą generacją modeli (np. GPT). |

| Złożone zadania | Długość zadań przy stałej skuteczności | Wykładniczy wzrost co kilka miesięcy. |

| Poziom ekspercki | Humanity’s Last Exam | Wzrost z ~3% do ~32% w niecały rok dla GPT-5. |

| Badania AI | RE-Bench | AI pokonuje ludzi w krótkich zadaniach; luka w długich zadaniach maleje. |

4. Rynki predykcyjne i deklaracje liderów

Rynki predykcyjne, takie jak Metaculus, odzwierciedlają zbiorową mądrość ekspertów. Obecnie przewidują one osiągnięcie „słabego AGI” pod koniec 2027 roku, a bardziej wymagającej definicji w 2029 roku (bez uwzględnienia robotyki).

Te prognozy są spójne z publicznymi deklaracjami liderów branży AI:

-

Elon Musk (xAI): Koniec 2025 lub początek 2026 roku.

-

Dario Amodei (Anthropic): 2026-2027 rok.

-

Sundar Pichai (Google): „Znaczny postęp” przed 2030 rokiem.

-

Sam Altman (OpenAI): 2028 rok.

Większość z nich lokuje nadejście AGI w perspektywie 2-5 lat. Ich działania – inwestowanie miliardów dolarów – są w pełni spójne z tymi deklaracjami.

„Teraz albo za bardzo długo”

Istnieje jeszcze jeden, kluczowy argument za tym, że AGI pojawi się w najbliższych latach. Obecne, wykładnicze tempo wzrostu inwestycji w AI i odkrywania „nisko wiszących owoców” w optymalizacji algorytmów jest nie do utrzymania w długim terminie. Nie możemy w nieskończoność zwiększać udziału AI w globalnym PKB.

Oznacza to, że znajdujemy się w unikalnym, historycznym oknie. Jeśli AGI ma powstać w wyniku obecnej fali rozwoju, stanie się to w ciągu najbliższych kilku lat. Jeśli nie, następna okazja może pojawić się dopiero za dekady.

Wnioski: Jesteśmy na progu nowej ery

Argumenty za rychłym nadejściem AGI i superinteligencji są spójne i wielowymiarowe. Opierają się na obserwowalnych trendach, prawach skalowania, prognozach rynkowych i strategicznych decyzjach największych firm technologicznych. Choć istnieją uzasadnione wątpliwości – czy moc obliczeniowa będzie rosła wystarczająco szybko, czy nie natrafimy na fundamentalne bariery w algorytmach, czy nie zabraknie nam danych – to dominująca narracja w sercu Doliny Krzemowej jest jasna: jesteśmy na ostatniej prostej.

Zrozumienie tej dynamiki jest kluczowe, nie tylko dla inwestorów, ale dla każdego z nas. Stoimy na progu transformacji, która może przyćmić rewolucję przemysłową i wynalezienie internetu. Analiza tych trendów, a zwłaszcza badanie punktu, w którym AI zaczyna autonomicznie przyspieszać własny rozwój, to jeden z najważniejszych i najbardziej fascynujących tematów badawczych naszych czasów. Projekt doktorski w tej dziedzinie mógłby nie tylko przyczynić się do rozwoju wiedzy, ale także pomóc w nawigowaniu przez bezprecedensowe wyzwania, które niesie ze sobą nadejście superinteligencji.

Najczęściej zadawane pytania (FAQ)

-

Czym superinteligencja różni się od AGI?

AGI (sztuczna ogólna inteligencja) to poziom, na którym AI dorównuje lub nieznacznie przewyższa człowieka w większości zadań poznawczych. Superinteligencja to kolejny etap – inteligencja, która radykalnie przewyższa najlepsze ludzkie umysły we wszystkich dziedzinach, w sposób dla nas niezrozumiały. Różnica jest nie ilościowa, ale jakościowa. -

Czy automatyzacja badaczy AI już się dzieje?

Tak, w coraz większym stopniu. Narzędzia AI są już używane do projektowania architektur sieci neuronowych (Neural Architecture Search), automatyzacji całego procesu tworzenia modeli (AutoML), a przede wszystkim do pisania kodu. W czołowych laboratoriach AI, takich jak OpenAI czy Anthropic, modele językowe piszą już znaczną część nowego kodu. -

Jakie są główne argumenty przeciwko temu, że AGI pojawi się tak szybko?

Główne kontrargumenty to: (1) Wyczerpanie danych: wkrótce możemy zużyć wszystkie dostępne, wysokiej jakości dane tekstowe do treningu. (2) Bariery algorytmiczne: obecne architektury (np. Transformery) mogą mieć fundamentalne ograniczenia, których nie da się przeskoczyć samym skalowaniem. (3) Wąskie gardła fizyczne: budowa centrów danych i produkcja chipów może nie nadążyć za rosnącym zapotrzebowaniem na moc obliczeniową. -

Dlaczego inwestycje w AI są „nie do utrzymania”?

Obecnie obserwujemy wykładniczy wzrost inwestycji w AI. Taki trend, z definicji, nie może trwać w nieskończoność, ponieważ w pewnym momencie wydatki na AI musiałyby przekroczyć wartość całej globalnej gospodarki. Oznacza to, że obecne tempo jest tymczasowe i w pewnym momencie musi wyhamować. -

Czy liderzy firm AI naprawdę wierzą w te krótkie terminy, czy to tylko marketing?

Chociaż w ich deklaracjach jest element marketingu, to skala inwestycji (setki miliardów dolarów w centra danych i chipy) sugeruje, że ich wiara w krótkie terminy jest autentyczna. Podejmują oni strategiczne decyzje biznesowe oparte na założeniu, że AGI jest osiągalne w perspektywie kilku lat.