Generatywna sztuczna inteligencja, z ChatGPT na czele, stała się stałym elementem warsztatu pracy milionów naukowców na całym świecie. Nie jest już nowinką technologiczną, lecz narzędziem codziennego użytku. Ta cicha rewolucja zmusza nas do postawienia fundamentalnych pytań: czy AI to super-asystent, który przyspieszy postęp naukowy, czy raczej generator problemów, który podkopuje fundamenty rzetelności badawczej? Zrozumienie tego zjawiska w oparciu o twarde dane jest kluczowe dla ustalenia zasad, które pozwolą nam mądrze korzystać z tej potężnej technologii.

AI w pisaniu naukowym: super-asystent czy generator problemów? Analiza 24 badań

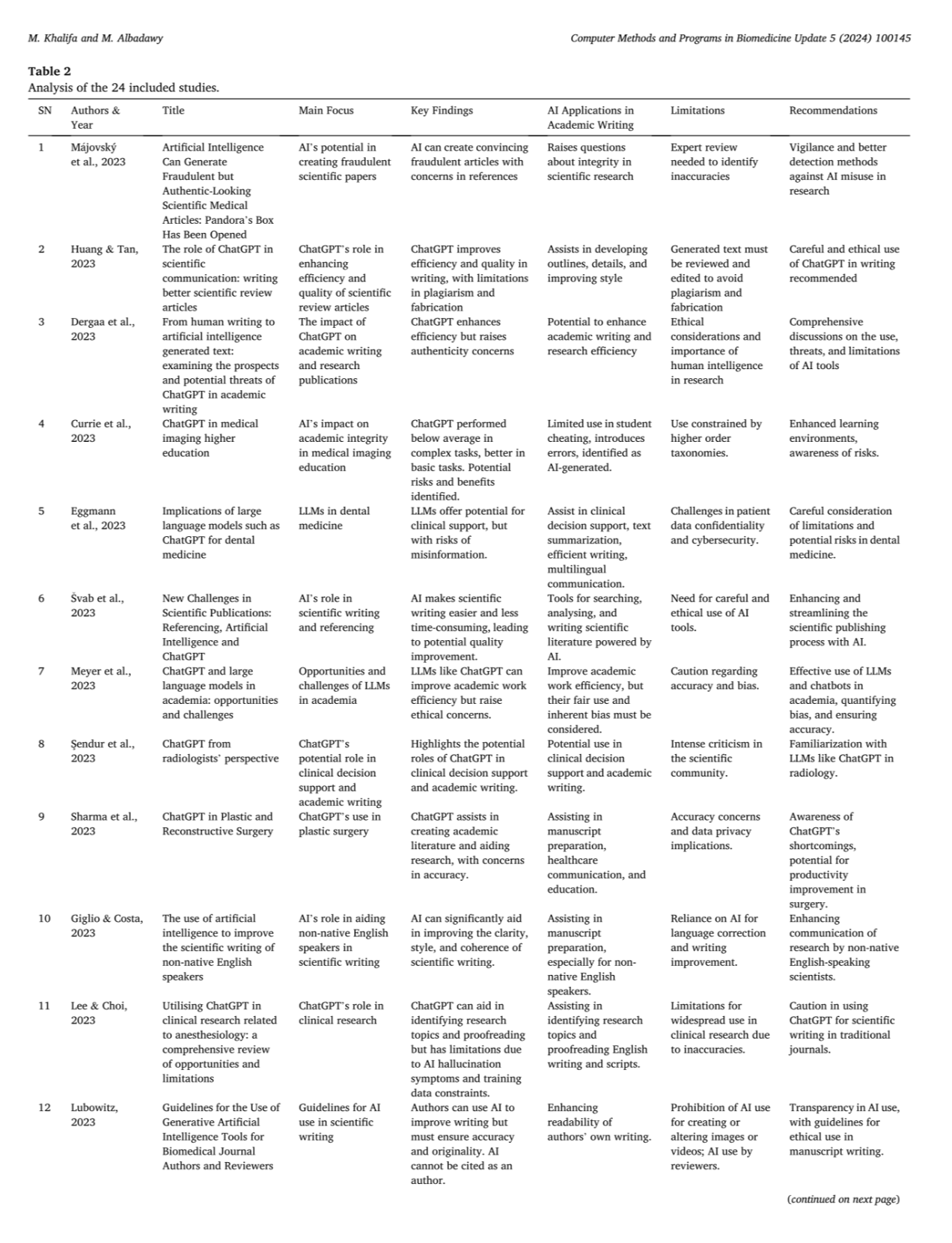

Sztuczna inteligencja (AI) w pisaniu naukowym to miecz o dwóch ostrzach. Z jednej strony obiecuje bezprecedensową wydajność, a z drugiej stwarza ryzyko związane z rzetelnością i oryginalnością. Aby oddzielić fakty od opinii, przeanalizowano wyniki systematycznego przeglądu 24 badań naukowych opublikowanych w 2023 roku. Badania te, prowadzone w różnych dziedzinach, od medycyny po nauki społeczne, rzucają światło na rzeczywisty wpływ narzędzi takich jak ChatGPT na proces badawczy.

Obietnica: AI jako akcelerator nauki

Przegląd badań jednoznacznie wskazuje, że główną i najczęściej potwierdzaną zaletą stosowania AI jest znaczący wzrost wydajności. Naukowcy mogą szybciej i łatwiej realizować zadania, które do tej pory były czasochłonne.

Kluczowe korzyści zidentyfikowane w badaniach:

-

Zwiększona efektywność: AI sprawia, że proces pisania staje się łatwiejszy i mniej czasochłonny. Automatyzuje tworzenie szkiców, streszczeń i pomaga w organizacji tekstu.

-

Poprawa jakości językowej: Narzędzia AI mogą znacząco poprawić klarowność, styl i spójność tekstu naukowego. Jest to szczególnie cenne dla badaczy, dla których język angielski nie jest językiem ojczystym, co pomaga wyrównywać szanse w globalnej nauce (badanie Giglio & Costa, 2023).

-

Wsparcie w procesie badawczym: AI asystuje nie tylko w pisaniu, ale także w identyfikacji tematów badawczych, wyszukiwaniu literatury i jej analizie, a nawet w komunikacji naukowej i edukacji (badanie Sharma et al., 2023).

Ryzyko: ciemna strona generatywnej AI

Jednakże, ten sam przegląd badań z równą siłą podkreśla, że korzyściom towarzyszy szereg poważnych zagrożeń. Nieuważne lub nieetyczne stosowanie AI może prowadzić do obniżenia standardów naukowych i podważenia zaufania do badań.

Główne zagrożenia i ograniczenia:

-

Niedokładność i fabrykacja: AI jest zdolna do tworzenia przekonujących, ale całkowicie fałszywych artykułów, włącznie z generowaniem nieistniejących źródeł i referencji (badanie Májovský et al., 2023). Zjawisko to, znane jako „halucynacje AI”, jest jednym z największych zagrożeń dla integralności naukowej.

-

Kwestie autentyczności i plagiatu: Zacieranie się granicy między tekstem stworzonym przez człowieka a maszynę rodzi poważne dylematy etyczne i pytania o autentyczność pracy (badanie Dergaa et al., 2023).

-

Utrata danych i poufność: W dziedzinach takich jak medycyna, wykorzystanie AI do analizy danych pacjentów stwarza poważne wyzwania związane z ochroną prywatności i cyberbezpieczeństwem (badanie Eggmann et al., 2023).

-

Konieczność nadzoru eksperckiego: Każdy tekst wygenerowany przez AI musi być poddany wnikliwej weryfikacji przez ludzkiego eksperta. Systemy te popełniają błędy, a ich identyfikacja wymaga głębokiej wiedzy dziedzinowej.

Złoty środek: AI jako kopilot, nie autopilot

Analiza 24 badań prowadzi do jednego, spójnego wniosku. Sztuczna inteligencja nie jest ani panaceum, ani śmiertelnym zagrożeniem. Jest potężnym narzędziem, którego wartość zależy od umiejętności i rzetelności badacza, który z niego korzysta. Rekomendacje płynące z badań skupiają się na trzech filarach odpowiedzialnego użytkowania.

| Filar | Rekomendacja | Przykład z badań |

| Przejrzystość | Autorzy powinni jasno deklarować użycie AI w procesie tworzenia publikacji. | Wprowadzenie wytycznych dla autorów i recenzentów, jak transparentnie raportować wykorzystanie AI (Lubowitz, 2023). |

| Odpowiedzialność | Ostateczna odpowiedzialność za treść, dokładność i rzetelność publikacji zawsze spoczywa na autorze-człowieku. | AI nie może być cytowana jako autor, ponieważ nie ponosi odpowiedzialności za swoją pracę (Lubowitz, 2023). |

| Weryfikacja | Każda informacja, referencja czy fragment tekstu wygenerowany przez AI musi być skrupulatnie zweryfikowany przez eksperta. | Potrzeba intensywnej krytyki i weryfikacji w społeczności naukowej, aby przeciwdziałać błędom i uprzedzeniom (Şendur et al., 2023). |

Podsumowując, AI w nauce to nie autopilot, który samodzielnie doprowadzi nas do celu. To zaawansowany kopilot, który może znacząco ułatwić podróż, ale to człowiek za sterami musi wyznaczać kurs, podejmować kluczowe decyzje i ponosić pełną odpowiedzialność za bezpieczeństwo i cel misji.

Najczęściej zadawane pytania (FAQ)

-

Czy AI może być uznana za współautora publikacji naukowej?

Nie. Przegląd badań, w tym wytyczne takie jak te przedstawione przez Lubowitz (2023), jest jednoznaczny: AI jest narzędziem, a nie twórcą. Nie posiada zdolności do ponoszenia odpowiedzialności za treść, co jest podstawowym warunkiem autorstwa. Odpowiedzialność w całości spoczywa na badaczach-ludziach. -

Jaki jest największy błąd, jaki naukowcy popełniają przy korzystaniu z AI?

Największym błędem jest bezkrytyczne zaufanie i brak weryfikacji. Traktowanie AI jako wyroczni, a nie asystenta, prowadzi do powielania błędów, fabrykowania cytowań i publikowania niedokładnych informacji. Kluczem jest sceptycyzm i rygorystyczne sprawdzanie każdego elementu wygenerowanego przez maszynę. -

Czy AI jest bardziej pomocna w konkretnych dziedzinach nauki?

Tak, choć jest użyteczna w wielu obszarach, jej zalety są szczególnie widoczne w zadaniach wymagających syntezy dużych ilości tekstu, poprawy jakości językowej (zwłaszcza dla osób nieanglojęzycznych) oraz w dziedzinach, gdzie struktura publikacji jest wysoce sformalizowana, np. w medycynie klinicznej czy naukach technicznych. -

Jak instytucje naukowe powinny reagować na upowszechnienie AI?

Instytucje powinny przyjąć proaktywną postawę, tworząc jasne wytyczne i polityki dotyczące etycznego i odpowiedzialnego korzystania z AI. Kluczowe jest organizowanie szkoleń dla studentów i pracowników naukowych, które podnoszą świadomość zarówno możliwości, jak i zagrożeń związanych z tymi narzędziami. -

Czy istnieją skuteczne narzędzia do wykrywania tekstu napisanego przez AI?

Istnieją takie narzędzia, ale ich skuteczność jest ograniczona i wciąż ewoluuje. Modele AI stają się coraz bardziej zaawansowane, a ich styl pisania coraz trudniejszy do odróżnienia od ludzkiego. Dlatego większy nacisk kładzie się na promowanie kultury przejrzystości i odpowiedzialności autorskiej niż na technologicznym „wyścigu zbrojeń”.

Publikacje wykonane przez nas w podobnej tematyce

-

Analiza wpływu GenAI na styl pisania naukowego i różnorodność leksykalną w publikacjach z lat 2023-2025.

-

Eksperymentalne badanie wpływu artykułów wspomaganych przez AI na proces recenzji naukowej i uprzedzenia recenzentów.

-

Opracowanie zautomatyzowanych metod wykrywania „halucynacji” referencyjnych w literaturze naukowej.

-

Ilościowa analiza korzyści płynących z użycia AI przez badaczy nieanglojęzycznych na podstawie wskaźników cytowań i akceptacji publikacji